Traffic von Suchmaschinen ist für jede Ressource am wünschenswertesten. Aber damit die Leute die Seite finden können Suchergebnisse, muss es zunächst in den Index gelangen. Manche Webmaster schenken dem nicht genug Aufmerksamkeit und hoffen, dass Suchmaschinen ihre Website oder ihre neuen Seiten selbst finden. Leider kann man sehr lange warten.

Besonders unterschiedlich ist hier die Indexierung der Site in Yandex. Wenn Google eine Seite buchstäblich innerhalb weniger Tage erfasst, dann ist die Hauptsuchmaschine des Runet ohne Hilfe von außen möglicherweise monatelang keine Aufmerksamkeit auf die Website richten.

Aber wir können alles reparieren. Wenn Sie wissen, wie Sie vorgehen müssen, kann Yandex Seiten innerhalb weniger Minuten nach ihrem Erscheinen indizieren. Und je schneller Ihre Einträge in der Datenbank dieser Suchmaschine erscheinen, desto schneller beginnt ihre Werbung – desto einfacher wird es, Besucher zu gewinnen und im Internet an Popularität zu gewinnen.

Wie schnell wird eine Website in Yandex indiziert?

Alle Ressourcen können basierend auf der Geschwindigkeit der Indizierung ihrer neuen Seiten in mehrere Gruppen eingeteilt werden:

- 1. Schnell indizierte Websites. Hierzu zählen vor allem Nachrichtenportale und bekannte Foren. Neue Einträge landen buchstäblich in wenigen Minuten im Index, was durchaus logisch ist – Nachrichten bleiben für sehr kurze Zeit Nachrichten. Auch ein schneller Einstieg in die Yandex-Datenbank wird durch ständig aktualisierte Vertrauensressourcen gewährleistet. Sie haben sein Vertrauen bereits durch die Qualität ihres Inhalts und ihres Alters gewonnen.

- 2. Gut indizierte Websites. Dies sind Ressourcen, die die Suchmaschine an regelmäßige Updates gewöhnt haben. Sie sind nicht unbedingt vertrauenswürdig oder alt, sondern erfreuen sowohl Benutzer als auch Suchmaschinen einfach ständig mit neuen Inhalten. Yandex behandelt solche Websites gut und Seiten werden nur für ein paar Tage aus dem Index entfernt.

- 3. Websites, die schwer zu indizieren sind. Dies gilt für neue Ressourcen, insbesondere wenn Webmaster keine Maßnahmen ergreifen, um sie bekannt zu machen. Darüber hinaus werden Websites, die über einen längeren Zeitraum nicht aktualisiert werden, schlecht indiziert. Wenn Sie mehrere Monate lang keine neuen Einträge hinzufügen, stoppt Yandex den Besuch der Website – sie kehrt zurück, wenn es Ihnen gefällt, Sie können sehr lange warten.

Dies ist die Klassifizierung. Es ist klar, dass es bedingt ist, basierend auf den Beobachtungen von Webmastern und Optimierern. Yandex wird niemandem sagen, nach welchem Prinzip es Websites indiziert und wie es bestimmt, wen es besuchen soll und wer seiner Aufmerksamkeit nicht würdig ist. Aus dieser Aufteilung lassen sich jedoch sehr nützliche Schlussfolgerungen ziehen.

Welche Websites werden von Yandex schnell indiziert:

- häufig aktualisiert: Je häufiger Datensätze erscheinen, desto schneller gelangen sie in den Index;

- Vertrauen: Alter, TIC-Indikator, Verkehr, Anzahl der Seiten – je mehr, je höher das Vertrauen von Yandex in die Website ist, desto häufiger kommt der Suchmaschinenroboter darauf.

Natürlich können auch andere Faktoren die Indexierung beeinflussen, etwa das Thema der Website, externe Links usw. Verhaltensfaktoren. Daher übernimmt niemand die Garantie für das schnelle Erscheinen von Seiten in den Suchergebnissen, auch nicht bei vertrauenswürdigen Websites. Ebenso wenig ist es notwendig, dass eine neu erstellte Website Monate auf die Indexierung in Yandex warten muss. Darüber hinaus können wir selbst einen gewissen Einfluss auf diesen Prozess nehmen.

Wie kann ich eine Website in Yandex schneller indizieren?

Um die Indexierung in Yandex zu beschleunigen, empfehlen wir den Kauf von Tweets an der Twitterstock-Börse; Sie können Tweets für 3 Rubel von Treuhandkonten kaufen. Der schnelle Roboter kommt sehr schnell an

Zunächst müssen Sie Ihre Website zum Yandex-Webmaster-Panel (Yandex.Webmaster) hinzufügen. Auf diese Weise benachrichtigen Sie die Suchmaschine über die Verfügbarkeit einer neuen Ressource. Der Vorgang ist einfach, aber sehr nützlich, insbesondere da er Ihnen die Möglichkeit gibt, zu überwachen, wie Ihre Website von Yandex wahrgenommen wird.

Darüber hinaus können Sie jede neue Seite zur Addurilka hinzufügen (im selben Yandex.Webmaster den Punkt „Neue Site melden“). Obwohl dies keine Garantie für die Indexierung ist, ist es nicht überflüssig.

- Erstellen Sie eine Sitemap: Die besten beiden Typen sind HTML für Benutzer und XML für Suchroboter. Dank dieser Seite kann Yandex sofort die Struktur der Website und alle ihre Einträge sehen und so alles schnell indizieren.

- Führen Sie interne Links durch: Links von einer Seite zur anderen führen die Suchmaschine durch die gesamte Ressource und nehmen die gefundenen Datensätze in den Index auf;

- Aktualisieren Sie die Website regelmäßig: Gewöhnen Sie Yandex daran, dass Sie ständig neue Einträge haben – und es wird die Ressource häufiger besuchen.

Um die Indexierung in Yandex zu beschleunigen, müssen Sie einen Suchroboter von anderen Ressourcen über externe Links auf Ihre Website locken:

- 1. Ankündigung in in sozialen Netzwerken und Blog-Plattformen. Dies ist vielleicht das aktuellste effektive Methode Beschleunigen Sie die Indizierung in Yandex. Beispielsweise können Links von Twitter einen Suchroboter in wenigen Minuten auf Ihre Website führen. Yandex liebt seine Idee – Ya.ru-Blogs. Beliebtes Werkzeug Für eine schnelle Indizierung gibt es auch VKontakte, LiveInternet, LiveJournal. Es ist klar, dass viel von der Werbung für das Konto oder Blog abhängt – wenn es sich außerhalb des Yandex-Index befindet, sollten Sie nicht erwarten, dass ein Link davon hilft.

- 2. Blog-Kommentare und Forenbeiträge. Besonders effektiv ist es, wenn diese Ressourcen gut indiziert sind – der Roboter folgt dem Link zu Ihrer Website sofort. Diese Methode eignet sich am besten, wenn Sie eine neue Site zum Yandex-Index hinzufügen müssen, da dieser Vorgang recht arbeitsintensiv ist und dazu verwendet werden kann, die Indexierung jeder einzelnen Site zu beschleunigen neuer Eintrag irrational.

- 3. RSS-Ausstrahlung in Fachkatalogen. Yandex besucht einige RSS-Verzeichnisse ziemlich oft. Wenn Sie also Ihre Website dort hinzufügen und neue Einträge gesendet werden, beschleunigt dies die Indexierung.

- 4. Hinzufügen zu sozialen Lesezeichen. MyPlace, BeaverDobr, Delicious und Toodoo sind die bekanntesten von ihnen. Suchmaschinen überwachen Aktualisierungen dieser Dienste, sodass Ihre Seiten alle Chancen haben, schnell in den Index aufgenommen zu werden.

- 5. Hinzufügen von Websites zu weißen Verzeichnissen. Besonders gut ist es, wenn es Ihrer Ressource gelingt, in Yandex.Catalog zu gelangen. Dies zeigt bereits das Vertrauen der Suchmaschine und die damit verbundene gute Indexierung an.

- 6. Links kaufen. Die effektivsten Links stammen von vertrauenswürdigen Quellen sowie von Nachrichtenportalen – diese selbst sind schnell indiziert und stellen diese auf Ihrer Website bereit. Sie können auch Links von Blogs wie Ya.ru oder LiveJournal bestellen – sie sind kostengünstig und funktionieren hervorragend.

Selbstverständlich kann diese Liste fortgeführt, ergänzt und aktualisiert werden. Vor allem, wenn man bedenkt, dass Suchmaschinen ihre Algorithmen ständig ändern und verbessern, was bedeutet, dass jede der Methoden irrelevant werden kann oder im Gegenteil mehr zur schnellen Indexierung der Website in Yandex beiträgt. Dies ist jedoch ein guter Anfang für die Website-Werbung – mit den oben aufgeführten Methoden können Sie Ihre Ressource den Suchmaschinen anzeigen und sie gleichzeitig verbessern und Ihre Linkmasse erhöhen.

Sehr oft kann eine neue Website in Yandex nicht gefunden werden. Auch wenn Sie den Namen in die Suchleiste eingeben. Die Gründe hierfür können unterschiedlich sein. Manchmal wissen Suchmaschinen einfach noch nicht, dass eine neue Ressource aufgetaucht ist. Um herauszufinden, was los ist, und das Problem zu lösen, müssen Sie Ihre Website bei Yandex.Webmaster registrieren.

Was ist Site-Indexierung in Yandex?

Lassen Sie uns zunächst herausfinden, wie Suchmaschinen im Allgemeinen von neuen Websites oder deren Änderungen erfahren. Yandex hat Sonderprogramm, der als Suchroboter bezeichnet wird. Dieser Roboter surft im Internet und sucht nach neuen Seiten. Manchmal geht er zu alten und prüft, ob dort etwas Neues aufgetaucht ist.

Wenn der Roboter eine nützliche Seite findet, fügt er sie seiner Datenbank hinzu. Diese Datenbank wird als Suchindex bezeichnet. Wenn wir in der Suche nach etwas suchen, sehen wir Seiten aus dieser Datenbank. Bei der Indexierung fügt der Roboter dort neue Dokumente hinzu.

Ein Roboter kann nicht jeden Tag das gesamte Internet durchsuchen. Dafür hat er nicht genug Kraft. Deshalb braucht er Hilfe – um über neue Seiten oder Änderungen an alten zu berichten.

Was ist Yandex.Webmaster und warum wird es benötigt?

Yandex.Webmaster ist offizieller Dienst von Yandex. Sie müssen ihm eine Website hinzufügen, damit der Roboter über deren Existenz Bescheid weiß. Mit seiner Hilfe können Ressourceneigentümer (Webmaster) nachweisen, dass es sich um ihre Website handelt.

Sie können auch im Webmaster sehen:

- wann und wo der Roboter eingetreten ist;

- welche Seiten indexiert wurden und welche nicht;

- Nach welchen Schlüsselwörtern wird gesucht?

- Gibt es technische Fehler?

Mit diesem Dienst können Sie eine Website einrichten: Legen Sie die Region und die Warenpreise fest und schützen Sie Ihre Texte vor Diebstahl. Sie können den Roboter bitten, die Seiten, auf denen Sie Änderungen vorgenommen haben, erneut zu besuchen. Yandex.Webmaster erleichtert den Wechsel zu https oder einer anderen Domain.

So fügen Sie Yandex.Webmaster eine neue Website hinzu

Gehen Sie zum Webmaster-Bereich. Klicken Sie auf „Anmelden“. Sie können den Benutzernamen und das Passwort eingeben, mit denen Sie sich bei Yandex Mail anmelden. Falls Sie es noch nicht haben Konto, müssen Sie sich registrieren.

Nach dem Anmelden werden Sie zu einer Seite mit einer Liste der hinzugefügten Ressourcen weitergeleitet. Wenn Sie den Dienst noch nicht genutzt haben, ist die Liste leer. Um eine neue Ressource hinzuzufügen, klicken Sie auf die Schaltfläche „+“.

Geben Sie auf der nächsten Seite die Adresse Ihrer Website ein und bestätigen Sie deren Hinzufügung.

Im letzten Schritt müssen Sie Ihre Rechte bestätigen- Beweisen Sie Yandex, dass Sie der Eigentümer sind. Dafür gibt es mehrere Möglichkeiten.

So bestätigen Sie Rechte an einer Website in Yandex.Webmaster

Der einfachste Weg, Rechte in Yandex.Webmaster zu bestätigen, ist Fügen Sie der Site eine Datei hinzu. Klicken Sie dazu auf den Reiter „HTML-Datei“.

Eine kleine Datei wird heruntergeladen. Sie benötigen diese Datei jetzt, also speichern Sie sie an einem Ort, an dem Sie sie sehen können. Zum Beispiel auf dem Desktop. Benennen Sie die Datei nicht um! Daran muss nichts geändert werden.

Laden Sie diese Datei nun auf Ihre Website hoch. Wird normalerweise hierfür verwendet Dateimanager, Aber Benutzer müssen nichts davon tun. Gehen Sie einfach ins Backoffice und klicken Sie auf „Dateien“. Dann oben auf der Seite – „Datei hinzufügen“. Wählen Sie die Datei aus, die Sie zuvor heruntergeladen haben.

Kehren Sie dann zum Yandex.Webmaster-Panel zurück und klicken Sie auf die Schaltfläche „Überprüfen“. Nach erfolgreicher Bestätigung der Zugriffsrechte erscheint Ihre Site in der Liste der hinzugefügten Sites. Damit haben Sie Yandex.Webmaster über die neue Website informiert.

Meta-Tag Yandex.Webmaster

Manchmal funktioniert die oben beschriebene Methode nicht und die Eigentümer können die Rechte an der Website im Webmaster nicht bestätigen. In diesem Fall können Sie eine andere Methode ausprobieren: Fügen Sie der Vorlage eine Codezeile hinzu.

Im Webmaster Gehen Sie zur Registerkarte „Meta-Tag“.. Sie sehen eine Zeile, die zum HTML-Code hinzugefügt werden muss.

Benutzer können sich an den technischen Support wenden und um die Eingabe dieses Codes bitten. Dies erfolgt im Rahmen einer kostenlosen Überarbeitung.

Wenn sie das tun Klicken Sie im Webmaster auf die Schaltfläche „Prüfen“.. Herzlichen Glückwunsch, Sie haben Ihre Website in einer Suchmaschine registriert!

Vorläufige Einrichtung von Yandex.Webmaster

Die Site wurde zur Suche hinzugefügt, jetzt wird der Roboter definitiv zu Ihnen kommen und sie indizieren. Dies dauert in der Regel bis zu 7 Tage.

Fügen Sie einen Link zu Ihrer Sitemap hinzu

Damit der Roboter die Ressource schneller indizieren kann, Fügen Sie die Datei sitemap.xml zum Webmaster hinzu. Diese Datei enthält die Adressen aller Seiten der Ressource.

In Online-Shops ist diese Datei bereits konfiguriert und sollte automatisch zum Webmaster hinzugefügt werden. Sollte dies nicht der Fall sein, fügen Sie im Abschnitt „Indexierung“ – „Sitemap-Dateien“ einen Link zu sitemap.xml hinzu.

Überprüfen Sie robots.txt

In der robots.txt-Datei Geben Sie Seiten an, die der Roboter nicht besuchen muss. Dies sind der Warenkorb, die Kasse, das Backoffice und andere technische Dokumente.

Standardmäßig wird robots.txt erstellt, das nicht geändert werden muss. Für alle Fälle empfehlen wir, die Roboter auf Fehler zu überprüfen. Gehen Sie dazu auf „Extras“ – „Analyse von robots.txt“.

Legen Sie die Site-Region fest

Auf der Seite „Site-Informationen“ – „Region“ können Sie die Region der Site festlegen. Bei Online-Shops sind dies die Städte, Regionen und Länder, in die die gekauften Waren geliefert werden. Wenn Sie keinen Shop, sondern ein Verzeichnis oder einen Blog haben, dann ist die Region die ganze Welt.

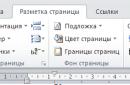

Legen Sie die Vertriebsregion wie im Screenshot gezeigt fest:

Wofür ist Webmaster sonst noch nützlich?

Auf der Seite „Suchanfragen“ können Sie die Phrasen sehen, die Ihnen bei der Suche einfallen.

Im Abschnitt „Indexierung“ werden Informationen darüber angezeigt, wann der Roboter auf der Website war und wie viele Seiten er gefunden hat. Der Unterabschnitt „Site-Verschiebung“ hilft Ihnen, wenn Sie sich für die Installation und den Wechsel zu https entscheiden. Der Unterabschnitt „Page Retraversal“ ist ebenfalls äußerst nützlich. Darin können Sie dem Roboter die Seiten anzeigen, auf denen sich die Informationen geändert haben. Bei Ihrem nächsten Besuch wird der Roboter sie dann zuerst indizieren.

Auf der Seite „Produkte und Preise“ im Bereich „Site-Informationen“ können Sie Informationen zu Ihrem Online-Shop bereitstellen. Dazu muss die Ressource so konfiguriert sein, dass sie Daten zu Produkten und Preisen im YML-Format hochlädt. Bei richtige Einstellung Preise und Lieferinformationen werden in den Suchergebnissen der Produktseiten angezeigt.

Wenn Sie die Sichtbarkeit Ihres Unternehmens in den Yandex-Diensten verbessern möchten, sollten Sie den Abschnitt „ Nützliche Dienste». In Yandex.Directory können Sie die Telefonnummer, die Adresse Ihres Geschäfts und die Öffnungszeiten angeben. Diese Informationen werden direkt in den Yandex-Ergebnissen angezeigt. Dadurch werden Sie auch zu Yandex.Maps hinzugefügt.

Yandex.Metrica - ein weiteres wichtiges Tool für den Besitzer einer Internetressource, das Verkehrsdaten anzeigt. Statistiken und Dynamik des Website-Verkehrs werden in leicht zu analysierenden Tabellen, Diagrammen und Grafiken angezeigt.

Nach der Verbindung mit den Diensten Yandex.Webmaster und Yandex.Metrica erhalten Sie ausreichend Informationen, um die Positionen und den Verkehr der Website zu verwalten. Dies sind unverzichtbare Tools für Websitebesitzer, die ihre Ressourcen in der beliebtesten Suchmaschine Russlands bewerben möchten.

Der nächste Schritt bei der Website-Werbung istüber einen ähnlichen Dienst Suchkonsole. Das ist alles, viel Glück bei Ihrer Beförderung!

Was ist Indizierung? Hierbei handelt es sich um den Prozess, bei dem ein Roboter den Inhalt der Seiten Ihrer Website empfängt und diesen Inhalt in die Suchergebnisse einbezieht. Wenn wir uns die Zahlen ansehen, enthält die Datenbank des Indexierungsroboters Billionen von Website-Seitenadressen. Täglich fordert der Roboter Milliarden solcher Adressen an.

Aber dieser ganze große Prozess der Indizierung des Internets kann in kleine Phasen unterteilt werden:

Zunächst muss der Indexierungsroboter wissen, dass eine Seite auf Ihrer Website erschienen ist. Zum Beispiel, indem Sie andere Seiten im Internet indizieren, Links finden oder das Set nemp herunterladen. Wir haben von der Seite erfahren und planen anschließend, diese Seite zu crawlen, Daten an Ihren Server zu senden, um diese Seite der Website anzufordern, den Inhalt zu empfangen und ihn in die Suchergebnisse aufzunehmen.

Bei diesem gesamten Prozess handelt es sich um den Austausch des Indexierungsroboters mit Ihrer Website. Wenn sich die vom Indexierungsroboter gesendeten Anfragen praktisch nicht ändern und sich nur die Seitenadresse ändert, hängt die Reaktion Ihres Servers auf die Seitenanfrage des Roboters von vielen Faktoren ab:

- aus Ihren CMS-Einstellungen;

- aus den Einstellungen des Hosting-Anbieters;

- aus der Arbeit des Zwischenanbieters.

Diese Antwort ändert sich gerade. Wenn Sie eine Seite anfordern, erhält der Roboter Ihrer Website zunächst die folgende Serviceantwort:

Dies sind HTTP-Header. Sie enthalten verschiedene Serviceinformationen, die es dem Roboter ermöglichen zu verstehen, welche Inhalte nun übermittelt werden.

Ich möchte mich auf den ersten Header konzentrieren – das ist der HTTP-Antwortcode, der dem Indexierungsroboter den Status der Seite anzeigt, die der Roboter angefordert hat.

Es gibt mehrere Dutzend solcher HTTP-Codestatus:

Ich erzähle Ihnen von den beliebtesten. Der häufigste Antwortcode ist HTTP-200. Die Seite ist verfügbar, kann indiziert werden, wird in die Suchergebnisse aufgenommen, alles ist in Ordnung.

Das Gegenteil dieses Status ist HTTP-404. Die Seite befindet sich nicht auf der Website, es gibt nichts zum Indexieren und es gibt nichts, was in die Suche einbezogen werden könnte. Wenn Sie die Struktur von Websites ändern und die Adressen interner Seiten ändern, empfehlen wir die Einrichtung eines 301-Servers zur Umleitung. Er wird den Roboter einfach darauf hinweisen alte Seite an eine neue Adresse verschoben und es ist notwendig, die neue Adresse in die Suchergebnisse aufzunehmen.

Wenn sich der Seiteninhalt seit dem letzten Besuch der Seite durch einen Roboter nicht geändert hat, ist es am besten, einen HTTP-304-Code zurückzugeben. Der Roboter erkennt, dass die Seiten in den Suchergebnissen nicht aktualisiert werden müssen und der Inhalt wird auch nicht übertragen.

Wenn Ihre Site nur für kurze Zeit verfügbar ist, beispielsweise während Arbeiten am Server ausgeführt werden, ist es am besten, HTTP-503 zu konfigurieren. Es zeigt dem Roboter an, dass die Site und der Server derzeit nicht verfügbar sind. Sie müssen etwas später zurückkehren. Bei kurzfristiger Nichtverfügbarkeit wird dadurch verhindert, dass Seiten aus den Suchergebnissen ausgeschlossen werden.

Zusätzlich zu diesen HTTP-Codes und Seitenstatus müssen Sie auch den Inhalt der Seite selbst direkt abrufen. Wenn die Seite für einen regelmäßigen Besucher so aussieht:

Das sind Bilder, Text, Navigation, alles ist sehr schön, dann ist für den Indexierungsroboter jede Seite nur ein Satz Quellcode, HTML-Code:

Verschiedene Meta-Tags, Textinhalte, Links, Skripte, viele Informationen aller Art. Der Roboter sammelt es und fügt es in die Suchergebnisse ein. Es scheint, dass alles einfach ist: Sie haben eine Seite angefordert, den Status erhalten, den Inhalt erhalten und ihn in die Suche einbezogen.

Doch nicht umsonst erhält der Yandex-Suchdienst mehr als 500 Briefe von Webmastern und Websitebesitzern, in denen es um bestimmte Probleme mit der Antwort des Servers geht.

Alle diese Probleme lassen sich in zwei Teile unterteilen:

Dies sind Probleme mit dem HTTP-Antwortcode und Probleme mit dem HTML-Code, mit dem direkten Inhalt der Seiten. Die Gründe für diese Probleme können vielfältig sein. Am häufigsten kommt es vor, dass der Indexierungsroboter vom Hosting-Anbieter blockiert wird.

Sie haben beispielsweise eine Website gestartet und einen neuen Abschnitt hinzugefügt. Der Roboter beginnt, Ihre Website häufiger zu besuchen, was die Belastung des Servers erhöht. Der Hosting-Anbieter sieht dies bei seiner Überwachung, blockiert den Indexierungsroboter und der Roboter kann daher nicht auf Ihre Website zugreifen. Sie gehen zu Ihrer Ressource – alles ist in Ordnung, alles funktioniert, die Seiten sind schön, alles öffnet sich, alles ist großartig, aber der Roboter kann die Site nicht indizieren. Wenn die Website vorübergehend nicht verfügbar ist, beispielsweise weil Sie vergessen haben zu bezahlen Domainname, die Seite ist seit mehreren Tagen nicht mehr verfügbar. Kommt der Roboter auf die Seite, ist er unzugänglich, unter solchen Bedingungen kann er nach einer Weile buchstäblich aus den Suchergebnissen verschwinden.

Falsch CMS-Einstellungen B. beim Update oder Wechsel zu einem anderen CMS, bei der Aktualisierung des Designs, kann bei falschen Einstellungen auch dazu führen, dass die Seiten Ihrer Website aus den Suchergebnissen verschwinden. Zum Beispiel das Vorhandensein eines verbotenen Meta-Tags in Quellcode Site-Seiten, falsche Einstellung des kanonischen Attributs. Stellen Sie sicher, dass die Seiten nach allen Änderungen, die Sie an der Website vornehmen, für den Roboter zugänglich sind.

Das Yandex-Tool hilft Ihnen dabei. An den Webmaster, um die Serverantwort zu überprüfen:

Sie können sehen, welche HTTP-Header Ihr Server an den Roboter zurückgibt und welche Inhalte die Seiten selbst enthalten.

Der Abschnitt „Indizierung“ enthält Statistiken, mit denen Sie sehen können, welche Seiten ausgeschlossen sind, die Dynamik der Änderungen dieser Indikatoren und verschiedene Sortier- und Filterfunktionen durchführen können.

Außerdem habe ich heute bereits über diesen Abschnitt gesprochen, den Abschnitt „Site-Diagnose“. Wenn Ihre Website für einen Roboter nicht mehr verfügbar ist, erhalten Sie eine entsprechende Benachrichtigung und Empfehlungen. Wie kann das behoben werden? Wenn keine derartigen Probleme auftreten, die Website zugänglich ist, die Codes 200 erfüllt und korrekte Inhalte enthält, beginnt der Roboter automatischer Modus Besuchen Sie alle Seiten, die er erkennt. Dies führt nicht immer zu den gewünschten Konsequenzen, sodass die Aktivitäten des Roboters in gewisser Weise eingeschränkt werden können. Hierfür gibt es eine robots.txt-Datei. Wir werden im nächsten Abschnitt darüber sprechen.

Robots.txt

Die robots.txt-Datei selbst ist klein Text dokument Es liegt im Stammordner der Site und enthält strenge Regeln für den Indexierungsroboter, die beim Crawlen der Site befolgt werden müssen. Die Vorteile der robots.txt-Datei bestehen darin, dass Sie für die Verwendung keine besonderen oder speziellen Kenntnisse benötigen.

Sie müssen lediglich Notepad öffnen, bestimmte Formatregeln eingeben und die Datei dann einfach auf dem Server speichern. Innerhalb eines Tages beginnt der Roboter, diese Regeln anzuwenden.

Nehmen wir ein Beispiel einer einfachen robots.txt-Datei, hier ist sie, direkt auf der nächsten Folie:

Die „User-Agent:“-Anweisung zeigt an, für welche Robots die Regel gedacht ist, und erlaubt/verweigert Anweisungen sowie zusätzliche Sitemap- und Host-Anweisungen. Ein bisschen Theorie, ich möchte zur Praxis übergehen.

Vor ein paar Monaten wollte ich einen Schrittzähler kaufen, also habe ich mich an Yandex gewandt. Bitten Sie den Markt um Hilfe bei der Auswahl. Von der Hauptseite von Yandex nach Yandex verschoben. Markt und angekommen Startseite Service.

Unten sehen Sie die Adresse der Seite, die ich aufgerufen habe. Die Adresse des Dienstes selbst fügte auch die Kennung von mir als Benutzer der Website hinzu.

Dann ging ich zum Abschnitt „Katalog“.

Ich habe den gewünschten Unterbereich ausgewählt und die Sortierparameter, Preis, Filter, Sortierung und Hersteller konfiguriert.

Ich habe eine Produktliste erhalten und die Seitenadresse ist bereits gewachsen.

Ich ging zum gewünschten Produkt, klickte auf die Schaltfläche „In den Warenkorb“ und fuhr mit der Kasse fort.

Während meiner kurzen Reise haben sich die Seitenadressen in gewisser Weise geändert.

Ihnen wurden Dienstparameter hinzugefügt, die mich als Benutzer identifizierten, die Sortierung einrichteten und dem Websitebesitzer anzeigten, von wo aus ich auf diese oder jene Seite der Website gelangte.

Ich denke, solche Seiten, Serviceseiten, werden für Suchmaschinennutzer nicht sehr interessant sein. Wenn sie dem Indexierungsroboter jedoch zur Verfügung stehen, können sie in die Suche einbezogen werden, da sich der Roboter im Wesentlichen wie ein Benutzer verhält.

Er geht zu einer Seite, sieht einen Link, auf den er klicken kann, geht dorthin, lädt die Daten in die Datenbank seines Roboters und setzt den Crawl der gesamten Website fort. In diese Kategorie solcher Adressen fallen beispielsweise auch personenbezogene Daten der Nutzer, etwa Lieferinformationen oder Kontaktdaten der Nutzer.

Natürlich ist es besser, sie zu verbieten. Genau dabei hilft Ihnen die robots.txt-Datei. Sie können heute Abend am Ende des Webmasters auf Ihre Website gehen, klicken und sehen, welche Seiten tatsächlich verfügbar sind.

Um robots.txt zu überprüfen, gibt es im Webmaster ein spezielles Tool:

Sie können Seitenadressen herunterladen, eingeben und prüfen, ob sie für den Roboter zugänglich sind oder nicht.

Nehmen Sie einige Änderungen vor und sehen Sie, wie der Roboter auf diese Änderungen reagiert.

Fehler beim Arbeiten mit robots.txt

Zusätzlich zu diesem positiven Effekt – dem Schließen von Serviceseiten – kann robots.txt bei falscher Handhabung einen grausamen Scherz spielen.

Erstens ist das häufigste Problem bei der Verwendung von robots.txt das Schließen wirklich notwendiger Seiten der Website, also derjenigen Seiten, die in der Suche enthalten sein und bei Suchanfragen angezeigt werden sollten. Bevor Sie Änderungen an robots.txt vornehmen, prüfen Sie unbedingt, ob die Seite, die Sie schließen möchten, bei Suchanfragen angezeigt wird. Möglicherweise befindet sich eine Seite mit einigen Parametern in den Suchergebnissen und Besucher gelangen über die Suche dorthin. Überprüfen Sie daher unbedingt, bevor Sie robots.txt verwenden und Änderungen daran vornehmen.

Zweitens: Wenn Ihre Website kyrillische Adressen verwendet, können Sie diese nicht direkt in robots.txt angeben; sie müssen codiert werden. Da robots.txt ein internationaler Standard ist, dem alle Indexierungsroboter folgen, müssen sie unbedingt codiert werden. Eine explizite Angabe des kyrillischen Alphabets ist nicht möglich.

Das dritthäufigste Problem sind unterschiedliche Regeln für unterschiedliche Robots verschiedener Suchmaschinen. Bei einem Indexierungsroboter wurden alle Indexierungsseiten geschlossen, beim zweiten wurde überhaupt nichts geschlossen. Infolgedessen ist in einer Suchmaschine alles in Ordnung, die gewünschte Seite befindet sich in der Suche, in einer anderen Suchmaschine kann es jedoch zu Müll, verschiedenen Müllseiten und etwas anderem kommen. Stellen Sie sicher, dass, wenn Sie ein Verbot festlegen, dies für alle Indexierungsroboter erfolgen muss.

Das vierthäufigste Problem ist die Verwendung der Crawl-Delay-Anweisung, wenn sie nicht erforderlich ist. Mit dieser Anweisung können Sie die Reinheit der Anfragen des Indexierungsroboters beeinflussen. Dies ist ein praktisches Beispiel, eine kleine Website, auf einem kleinen Hosting platziert, alles ist in Ordnung. Wir fügten einen großen Katalog hinzu, der Roboter kam, sah eine Menge neuer Seiten, begann häufiger auf die Seite zuzugreifen, erhöhte die Last, lud sie herunter und die Seite wurde unzugänglich. Wir setzen die Crawl-Delay-Anweisung, der Roboter sieht das, reduziert die Last, alles ist in Ordnung, die Seite funktioniert, alles ist perfekt indiziert, es ist in den Suchergebnissen. Nach einiger Zeit wächst die Site noch weiter, wird auf ein neues Hosting übertragen, das diese Anfragen mit einer großen Anzahl von Anfragen bewältigen kann, und sie vergessen, die Crawl-Delay-Anweisung zu entfernen. Dadurch erkennt der Roboter, dass viele Seiten auf Ihrer Website erschienen sind, kann diese jedoch allein aufgrund der festgelegten Richtlinie nicht indizieren. Wenn Sie jemals die Crawl-delay-Anweisung verwendet haben, stellen Sie sicher, dass sie jetzt nicht vorhanden ist und dass Ihr Dienst bereit ist, die Last des Indexierungsroboters zu bewältigen.

Zusätzlich zu der beschriebenen Funktionalität können Sie mit der robots.txt-Datei zwei sehr wichtige Aufgaben lösen: Duplikate auf der Site entfernen und die Adresse des Hauptspiegels angeben. Genau darüber werden wir im nächsten Abschnitt sprechen.

Doppel

Unter Duplikaten verstehen wir mehrere Seiten derselben Website, die absolut identische Inhalte enthalten. Das häufigste Beispiel sind Seiten mit und ohne Schrägstrich am Ende der Adresse. Unter einem Duplikat kann auch das gleiche Produkt in verschiedenen Kategorien verstanden werden.

Rollschuhe können beispielsweise für Mädchen sein, für Jungen kann das gleiche Modell in zwei Abschnitten gleichzeitig sein. Und drittens handelt es sich um Seiten mit einem unbedeutenden Parameter. Wie im Beispiel mit Yandex. Der Markt definiert diese Seite als „Session-ID“, dieser Parameter ändert grundsätzlich nichts am Inhalt der Seite.

Um Duplikate zu erkennen und zu sehen, auf welche Seiten der Roboter zugreift, können Sie Yandex verwenden. Webmaster.

Neben Statistiken gibt es auch Adressen von Seiten, die der Roboter heruntergeladen hat. Sie sehen den Code und den letzten Anruf.

Probleme, zu denen Duplikate führen

Was ist so schlimm am Doppel?

Erstens beginnt der Roboter, auf absolut identische Seiten der Site zuzugreifen, was nicht nur eine zusätzliche Belastung für Ihren Server darstellt, sondern sich auch auf das Crawling der Site insgesamt auswirkt. Der Roboter beginnt, auf doppelte Seiten zu achten und nicht auf die Seiten, die indiziert und in die Suchergebnisse aufgenommen werden müssen.

Das zweite Problem besteht darin, dass doppelte Seiten, wenn sie für den Roboter zugänglich sind, in den Suchergebnissen landen und mit den Hauptseiten um Suchanfragen konkurrieren können, was sich natürlich negativ auf die Website auswirken kann, die bei bestimmten Suchanfragen gefunden wird.

Wie gehen Sie mit Duplikaten um?

Zunächst empfehle ich die Verwendung des „canonical“-Tags um den Roboter auf die kanonische Hauptseite zu verweisen, die indiziert und in Suchanfragen gefunden werden soll.

Im zweiten Fall können Sie eine 301-Server-Weiterleitung verwenden, beispielsweise für Situationen mit einem Schrägstrich am Ende der Adresse und ohne Schrägstrich. Wir haben eine Umleitung eingerichtet – es gibt keine Duplikate.

Und drittens ist dies, wie ich bereits sagte, die robots.txt-Datei. Sie können sowohl deny-Anweisungen als auch die Clean-param-Anweisung verwenden, um unbedeutende Parameter zu entfernen.

Site-Spiegel

Die zweite Aufgabe, die Sie mit robots.txt lösen können, besteht darin, den Roboter auf die Adresse des Hauptspiegels zu verweisen.

Mirrors sind eine Gruppe von Sites, die absolut identisch sind, wie Duplikate, nur dass die beiden Sites unterschiedlich sind. Webmaster stoßen in der Regel in zwei Fällen auf Mirrors – wenn sie dorthin wechseln möchten neue Domäne, oder wenn der Benutzer mehrere Website-Adressen verfügbar machen muss.

Sie wissen beispielsweise, dass Benutzer, wenn sie Ihre Adresse oder die Adresse Ihrer Website in die Adressleiste eingeben, oft den gleichen Fehler machen – sie schreiben falsch, geben das falsche Zeichen ein oder etwas anderes. Sie können eine zusätzliche Domain erwerben, um Benutzern nicht einen Stub des Hosting-Anbieters, sondern die Seite anzuzeigen, zu der sie wirklich gehen wollten.

Konzentrieren wir uns auf den ersten Punkt, denn genau hier treten bei der Arbeit mit Spiegeln am häufigsten Probleme auf.

Ich rate Ihnen, den gesamten Umzugsvorgang gemäß den folgenden Anweisungen durchzuführen. Eine kleine Anleitung, mit der Sie verschiedene Probleme beim Umzug auf einen neuen Domainnamen vermeiden können:

Zunächst müssen Sie Websites für den Indexierungsroboter zugänglich machen und absolut identische Inhalte darauf platzieren. Stellen Sie außerdem sicher, dass der Roboter über die Existenz der Websites Bescheid weiß. Der einfachste Weg besteht darin, sie zu Yandex hinzuzufügen. Webmaster und bestätigen Sie die Rechte daran.

Zweitens verweisen Sie den Roboter mithilfe der Host-Direktive auf die Adresse des Hauptspiegels – denjenigen, der indiziert werden und in den Suchergebnissen erscheinen soll.

Wir warten auf die Verklebung und Übertragung aller Indikatoren von der alten auf die neue Seite.

Anschließend können Sie eine Umleitung von der alten zur neuen Adresse einrichten. Eine einfache Anleitung: Wenn Sie umziehen, sollten Sie diese unbedingt verwenden. Ich hoffe, dass es keine Probleme damit geben wird

ziehen um.

Bei der Arbeit mit Spiegeln treten jedoch natürlich auch Fehler auf.

Zunächst einmal das Meiste das Hauptproblem– Dies ist das Fehlen expliziter Anweisungen für den Indexierungsroboter zur Adresse des Hauptspiegels, der Adresse, die in der Suche enthalten sein sollte. Überprüfen Sie auf Ihren Websites, ob die robots.txt-Datei eine Host-Anweisung enthält und dass diese genau auf die Adresse verweist, die Sie in der Suche sehen möchten.

Das zweithäufigste Problem ist die Verwendung der Umleitung zum Ändern des Hauptspiegels in einer vorhandenen Gruppe von Spiegeln. Was ist los? Da die alte Adresse umleitet, wird sie vom Roboter nicht indiziert und aus den Suchergebnissen ausgeschlossen. In diesem Fall erscheint die neue Site nicht in der Suche, da es sich nicht um den Hauptspiegel handelt. Man verliert Verkehr, man verliert Besucher, ich denke, das braucht niemand.

Und das dritte Problem ist die Unzugänglichkeit eines der Spiegel beim Bewegen. Das häufigste Beispiel in dieser Situation ist, dass sie den Inhalt der Website an eine neue Adresse kopiert haben, die alte Adresse jedoch einfach deaktiviert wurde, sie nicht für den Domainnamen bezahlt haben und dieser nicht mehr verfügbar war. Selbstverständlich werden solche Seiten nicht zusammengeführt, sie müssen für den Indexierungsroboter zugänglich sein.

Nützliche Links im Werk:

- Mehr nützliche Informationen Sie finden es im Yandex.Help-Dienst.

- Alle Tools, über die ich gesprochen habe, und noch mehr – es gibt eine Beta-Version von Yandex.Webmaster.

Antworten auf Fragen

„Vielen Dank für den Bericht. Ist es notwendig, die Indizierung von CSS-Dateien für den Roboter in robots.txt zu deaktivieren oder nicht?

Wir empfehlen, sie zum jetzigen Zeitpunkt nicht zu schließen. Ja, CSS JavaScript ist besser Gehen Sie, denn jetzt arbeiten wir daran, sicherzustellen, dass der Indexierungsroboter beginnt, sowohl Skripte auf Ihrer Website als auch Stile zu erkennen und zu sehen, wie sich ein Besucher in einem normalen Browser verhält.

„Sagen Sie mir, wenn die Site-URLs für die alte und die neue identisch sind, ist das normal?“

Es ist okay. Im Grunde aktualisieren Sie einfach das Design und fügen Inhalte hinzu.

„Die Site hat eine Kategorie und besteht aus mehreren Seiten: Slash, Seite1, Seite2, bis zu 10 zum Beispiel. Alle Seiten haben denselben Kategorietext und es stellt sich heraus, dass er doppelt vorhanden ist. Wird dieser Text ein Duplikat sein oder sollte er irgendwie geschlossen werden, ein neuer Index auf der zweiten und weiteren Seiten?

Erstens: Da die Paginierung auf der ersten Seite und der Inhalt auf der zweiten Seite im Allgemeinen unterschiedlich sind, handelt es sich nicht um Duplikate. Sie müssen jedoch damit rechnen, dass die Seiten mit der zweiten, dritten und weiteren Paginierung in die Suche gelangen und bei einer relevanten Suchanfrage angezeigt werden. Bei Paginierungsseiten würde ich besser die Verwendung des kanonischen Attributs empfehlen, im besten Fall auf der Seite, auf der alle Produkte gesammelt werden, damit der Roboter keine Paginierungsseiten in die Suche einbezieht. Auf der ersten Seite der Paginierung wird häufig die kanonische Schriftart verwendet. Der Roboter kommt auf die zweite Seite, sieht das Produkt, sieht den Text, nimmt die Seite nicht in die Suche auf und versteht aufgrund des Attributs, dass es sich um die erste Paginierungsseite handelt, die in die Suchergebnisse aufgenommen werden soll. Verwenden Sie Canonical und schließen Sie den Text selbst. Ich denke, das ist nicht nötig.

Quelle (Video): So richten Sie die Site-Indexierung ein- Alexander Smirnow

Magomed Tscherbizhev

Sie haben eine Website erstellt, können diese aber in Suchmaschinen nicht finden? Kein Problem! In diesem Material erfahren Sie, wie Sie eine Website in Yandex und Google in kürzester Zeit indizieren. Es ist wahrscheinlich unnötig, über die Vorteile eines schnellen Einstiegs in den Suchmaschinenindex zu sprechen. Schließlich versteht jeder, dass neue Kunden umso schneller erscheinen, je früher seine Website in den Suchergebnissen angezeigt wird. Und damit dies funktioniert, müssen Sie in die Datenbank der Suchmaschine gelangen.

Übrigens, danke der richtige Ansatz, neue Materialien auf unserer Website sind recht gut und vor allem werden sie von Suchmaschinen immer schnell indiziert. Möglicherweise sind Sie auf diese Seite gelangt, nachdem Sie die entsprechende Suchanfrage in der Suchleiste eingegeben haben. Kommen wir vom Text zum Üben.

Wie finde ich heraus, ob eine Website indexiert ist?

Als Erstes müssen Sie herausfinden, ob die Website von Suchmaschinen indiziert wird. Möglicherweise befindet sich die Website einfach nicht auf der ersten Seite der Suche nach der von Ihnen eingegebenen Suchanfrage. Hierbei kann es sich um Suchanfragen mit hohem Volumen handeln, die bearbeitet werden müssen, damit sie angezeigt werden SEO-Werbung, und nicht nur eine Website erstellen und starten.

Um dies zu überprüfen, gehen wir also zu allen Suchmaschinen, die sinnvoll sind ( Yandex, Google, Mail, Rambler) und zur Linie Suchanfrage Geben Sie die Site-Adresse ein.

Wenn Ihre Ressource noch nicht indiziert wurde, wird in den Suchergebnissen nichts angezeigt oder es werden andere Websites angezeigt.

Wie indiziere ich eine Website in Yandex?

Zunächst erklären wir Ihnen, wie Sie eine Website in Yandex indizieren. Aber bevor Sie Ihre Ressource hinzufügen, überprüfen Sie, ob sie ordnungsgemäß funktioniert, auf allen Geräten korrekt geöffnet wird und nur enthält einzigartiger Inhalt. Wenn Sie beispielsweise in der Entwicklungsphase eine Website hinzufügen, können Sie einfach unter den Filter fallen – das ist uns einmal passiert und wir mussten einen ganzen Monat warten, bis Yandex erkannte, dass wir eine qualitativ hochwertige Website haben, und die Sanktionen aufhob .

Um Yandex über eine neue Website zu informieren, müssen Sie Fügen Sie es zu Yandex Webmaster hinzu Und Installieren Sie Yandex Metrica, dafür ist das erste Tool verantwortlich Weitere Informationenüber die Ressource ( Region, Struktur, Quicklinks) und wie die Website in organischen Ergebnissen aussieht, der zweite zum Sammeln von Daten auf der Website ( Anwesenheit, Verhalten usw.), was sich unserer Erfahrung nach auch auf die Indexierung der Seite und ihre Position in der Suche auswirkt. Stellen Sie außerdem sicher, dass Sie eine Sitemap erstellen und diese im Webmaster-Panel angeben.

Wie indiziere ich eine Website in Google?

In den meisten Fällen findet Google selbst schnell neue Websites und stellt sie in die Suche ein. Aber darauf zu warten, dass Google kommt und die ganze Arbeit für uns erledigt, ist zu anmaßend. Lassen Sie uns also herausfinden, wie Sie eine Website in Google indizieren.

Nachdem die Sites hinzugefügt wurden, sollte es durchgehen von 3 bis 7 Tagen, bevor Suchmaschinen die Daten aktualisieren und die Website indizieren.

Sie möchten immer, dass neue Website-Seiten so schnell wie möglich in den Suchergebnissen erscheinen. Dafür gibt es mehrere geheime (und sehr einfache) Möglichkeiten, die Indexierung von Website-Seiten zu beschleunigen Suchmaschinen.

3. Um die in Absatz 2 beschriebene Manipulation nur für die Google-Suchmaschine durchzuführen, gehen Sie zur Search Console. Wählen Sie „Scannen“ und „Sehen wie Googlebot“-Fügen Sie die Adresse hinzu neue Seite und klicken Sie auf „Scannen“, woraufhin wir die Indizierung anfordern.

Analyse der Site-Indizierung

Abschließend ist festzuhalten, dass die Arbeit auch nach erfolgreicher Indexierung der Seite in Suchmaschinen noch nicht beendet ist. Es ist notwendig, die Indizierung der Website regelmäßig zu analysieren und Positionen für häufig gestellte Fragen zu entfernen. So bleiben Sie am Puls der Zeit und geraten nicht in eine Situation, in der ein erheblicher Teil des Traffics aus den organischen Suchergebnissen einfach verschwunden ist.

Dies geschah bei vielen alten Websites, die nach der Veröffentlichung alte Werbemethoden verwendeten Yandex-Algorithmus Baden-Baden. Gleichzeitig kündigte Yandex im Vorfeld an, diesen Algorithmus einzuführen und überoptimierte Seiten von der Suche auszuschließen, während Google nie die Veröffentlichung neuer Algorithmen meldet. Deshalb können Sie nur durch unermüdliches Beobachten ein Themenführer bleiben oder werden!